Le 7 juin, au Salon européen de la recherche et de l'innovation, le freezing est devenue une arme politique du mouvement Sauvons la recherche. Sauf qu'ils ont encore du progrès à faire, on voit un gars bouger à la 37e seconde et une nana à la 54e et à mon avis, la vidéo serait bien plus percutante si elle s'ouvrait sur la mise en place du freezing…

Le 3 juin, un candidat américain promettait vaguement de renewing our commitment to science and innovation

. Mais ces quelques mots prononcés par Obama ne sont pas passés inaperçus tant les américains en veulent aux républicains d'avoir fait du mal à leur science.

En juin, le magazine ''research*eu'' de la Commission européen (DG Recherche) nous gratifait d'un beau lieu commun : dans une époque surchargée de communiqués de presse, blogs et autres wikis, personne n'est à l'abri de l'inexactitude, encore moins lorsqu'il s'agit de science

(p. 14).

Le 19 juin, la revue Nature frôlait le numéro spécial sur la fraude scientifique avec un éditorial, l'annonce de la suspension d'un chercheur mal intentionné à l'Université de Pennsylvanie et une enquête montrant que seulement 58 % des 201 comportements frauduleux observés par les 2,212 chercheurs interrogés ont été signalés à la hiérarchie ces trois dernières années. Et les 24 cas soumis chaque année en moyenne par les institutions de recherche à l'Office of Research Integrity américain ne sont que le sommet de l'iceberg... Ce qu'il manque, affirment les auteurs de l'étude ? Une culture de l'intégrité dans les labos.

Le 23 juin, un article du rédacteur en chef de Wired, le père de la "longue traîne" Chris Anderson, annonçait la fin de la théorie et le début de la science empirique basée sur les quantités colossales de données dont on dispose désormais. Un peu comme Google qui ne fait aucune hypothèse et modèle mais rend compte de nos habitudes et notre langage en moulinant des pétaoctets de données dans des serveurs équipés d'algorithmes surpuissants. Mais à la question qu'est-ce que la science peut apprendre de Google ?

, Alexandre Delaigue apporte une réponse très réservée tandis que Gloria Origgi de l'Institut Nicod s'enthousiasme beaucoup plus.

Les deux élèves-ingénieurs français tués à Londres le 29 juin étaient des… spécialistes de l'ADN

selon l'article du Monde. Or une enquête rapide montre que Laurent Bonomo étudiait un parasite qui se transmet des chats aux foetus

c'est-à -dire Toxoplasma gondii, probablement dans ce labo. Gabriel Ferrez, lui, étudiait des bactéries capables de créer de l'éthanol utilisable comme biocarburant

, probablement dans cet autre labo. On est loin de simples spécialistes de l'ADN, une dénomination qui équivaut sans doute pour Le Monde à un synonyme de "biologiste"...

En juillet, nous apprenions l'étonnant destin de l'article en français le plus cité de la base bibliographique Scopus (plus de 500 citations), lequel posait les bases de la vertebroplastie en 1987.

Le 11 juillet paraissait dans Science un article (en accès libre ici) de sociologues des médias étudiant l'attitude des chercheurs face aux journalistes scientifiques. Le résultat selon lequel 46 % des chercheurs interrogés ont une expérience plutôt positive d'un tel contact, venant à l'encontre d'autres études, a été longuement commenté.

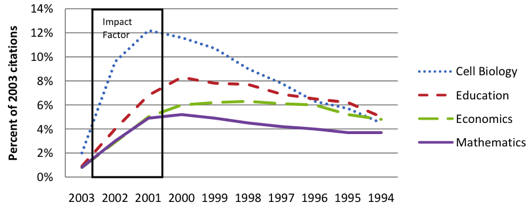

Dans son numéro suivant, Science frappait à nouveau un grand coup avec un article de James Evans montrant que la mise en ligne des publications scientifiques entraîne un appauvrissement des citations bibliographiques (les articles cités sont de plus en plus jeunes et de moins en moins variés). Selon l'auteur, ce serait parce qu'en naviguant en ligne on a plus tendance à être guidé vers les articles clés d'un domaine (en mode suivi des liens hypertextes "Voir aussi...") et à faire un choix plus strict des références à citer (puisqu'elles sont accessibles et vérifiables en ligne). Fini notamment l'heureux hasard ("sérendipité") qui permettait, en potassant les sommaires d'une revue, de faire des rapprochements inattendus et d'explorer des voies de traverse. Le consensus se construit désormais à vitesse grand V. Le magazine The Economist y voit la fin de la longue traîne dans les citations (via l'Agence Science-Presse). Stevan Harnad, en tous cas, fait le tri entre les diverses explications de ce phénomène, tout comme un commentaire de la revue Science...

Le 20 juillet à l'Euroscience Open Forum de Barcelone, des experts ont appelé à la prise en compte des risques toxicologiques des nanotechnologies. Il semble en effet que des résultats scientifiques récents mettent en évidence l'existence de risques brandits depuis longtemps...

Le 29 juillet, un éditorial de la revue Genome Biology se moquait gentiment du facteur d'impact en imaginant que le même système est appliqué pour décider si l'on est envoyé au paradis ou en enfer (via Pawel). Extrait :

Genome Biology : Ecoutez, une fois que le facteur d'impact a dominé l'évaluation de la science, les chercheurs créatifs ont été maudits. Les bureaucrates n'ont plus eu à connaître quoi que ce soit ou avoir un semblant de sagesse ; tout ce qu'ils avaient à faire était de se fier à quelques nombres arbitraires. Et maintenant vous me dites que vous faites cela pour déterminer qui va au paradis ?

Saint Pierre : Oui, c'est beaucoup plus simple. Peu importe si vous avez été gentil ou avez fait de votre mieux ou avez bien travaillé ou avez été pieux ou modeste ou généreux. La seule chose qui compte c'est de calculer si vous avez eu un gros impact.

Derniers commentaires