Ceci est un article qui pourrissait dans un coin de mon disque dur après avoir été refusé par la revue Terminal fin 2006. Je l'ai exhumé à la faveur d'un billet de David et d'une note du Centre d'analyse stratégique. Certes il est perfectible sur certains points mais je crois qu'il apporte un éclairage intéressant sur le sujet, qu'il s'efforce d'être pédagogique et qu'il est d'actualité. Un bon billet, quoi ;-)

Depuis qu'il existe, le système moderne des brevets n'a jamais été autant discuté, élargi, revu, avec pour conséquence d'affronter une contestation croissante — ou une satisfaction mal dissimulée, selon le bord de chacun. Mais délaissons un instant ces facteurs externes pour étudier les limites intrinsèques du système à travers un indicateur de plus en plus en vogue : la qualité des brevets. Celle-ci peut s'apprécier de diverses façons, n'est pas forcément facile à définir, mais les acteurs s'accordent à reconnaître un brevet de mauvaise qualité quand ils en voient un ! Surtout, elle est la pierre de touche du système, l'aune à laquelle se mesure son efficacité interne, et le témoin idéal des tendances sur le long terme.

Un constat inéluctable

C'est un fait désormais avéré, la qualité moyenne des brevets est en baisse. Sur ce constat se rejoignent de nombreux observateurs, acteurs et groupements d'acteurs, aux Etats-Unis comme en Europe ; les systèmes asiatiques des brevets (notamment en Chine, Corée et au Japon) sont encore trop récents et mouvants pour être étudiés sous cet angle. Ce sont même surtout les brevets américains qui sont visés et inspireront la plupart des exemples ci-après. Ainsi, l'Association des détenteurs de droits de propriété intellectuelle (IPO) a publié en septembre 2005 le résultat d'une enquête menée auprès de ses membres sur la perception de la qualité des brevets aux Etats-Unis ; 80 entreprises ont répondu, tous secteurs et tailles confondus. Il apparaît que 48,8 % des répondants jugent la qualité des brevets délivrés aux Etats-Unis satisfaisante et plus que satisfaisante contre 51,2 % qui la jugent moins que satisfaisante et pauvre. Les plus sévères sont les entreprises des secteurs chimique, pharmaceutique et biotechnologique. 24,1 % des entreprises estiment que la qualité moyenne s'est dégradée dans les trois dernières années, surtout dans les secteurs mentionnés précédemment. Enfin, les répondants sont pessimistes puisqu'ils estiment à 28,7 % que cette qualité va encore se dégrader dans les trois prochaines années, à 67,5 % que la procédure de délivrance des brevets va se rallonger et à 73,8 % que les ressources mobilisées par les litiges sur les brevets vont augmenter !

A peine deux mois plus tard, la présidente du Groupe européen d'information brevet (PDG) qui regroupe 38 entreprises multinationales parmi les plus importantes tous secteurs confondus prenait la parole sur ce sujet au Congrès sur l'information brevet de l'Office européen des brevets (OEB). Dans la version écrite de sa présentation, M. Philipp s'inquiète que « l'augmentation du nombre de brevets conduit à une diminution de leur qualité ».

Auparavant, des signaux avaient été envoyés par les examinateurs même des offices des brevets ! En avril 2004, un sondage effectué en interne à l'OEB montrait que plus de 75 % des examinateurs estiment que la productivité qu'on exige d'eux les empêche de « faire respecter les standards de qualité définis par la Convention sur le brevet européen », 66 % d'entre eux considèrent manquer de temps pour effectuer les examens de brevets « d'une manière satisfaisante » et seulement 9 % croient que le management est « engagé activement à l'amélioration de la qualité ». Fin 2006, plus de la moitié d'entre eux se mettaient en grève pour protester contre une réforme dont l'une des principales conséquences, et en tous cas la plus gênante, serait la délivrance accrue de brevets de mauvaise qualité. Un symptôme parmi d'autres, le manque de temps empêchait de mettre en œuvre l'examen croisé comme contrôle de qualité interne. Il avait été aussi constaté que le taux de délivrance (nombre de brevets délivrés divisé par le nombre de demandes) entre 1993 et 1998 était de 85 % aux Etats-Unis contre moins de 67 % en Europe et 64 % au Japon, preuve d'un apparent laxisme et d'une moindre exigence des examinateurs outre-Atlantique.

L'inquiétude est donc bien réelle parmi les acteurs de l'industrie et confirmée par les observateurs académiques et institutionnels. Il n'en va pas que de l'économie d'une société basée sur la connaissance mais aussi de la viabilité d'un système devenu aussi puissant et prégnant que le système des brevets l'est actuellement.

Ce que l'on entend par brevets de mauvaise qualité

Qu'est-ce que ce constat recouvre en pratique ? De nombreux facteurs jouent sur la qualité réelle et perçue et tous n'ont pas la même importance. Entreprenons ensemble un parcours à travers les exemples les plus variés et significatifs.

La demande de brevet

Au commencement du brevet se trouve la demande de brevet, rédigée par l'inventeur en collaboration étroite avec son conseil en propriété intellectuelle. Celle-ci décrit l'invention et fixe les premières limites aux revendications. Les offices des brevets étudiés ici publient la demande dix-huit mois après dépôt, sans autre modification qu'une simple mise en forme. Cette première publication importante, qui forme la base d'une nouvelle famille de brevets, peut déjà être de mauvaise qualité si elle comporte des erreurs et fautes d'orthographe — ce qui est presque toujours le cas nous apprend un rapport de l'entreprise Intellevate de janvier 2006 — et si celles-ci entachent et fragilisent les revendications — 2 % des cas. Une faute d'orthographe n'est pas non plus toujours triviale dans le sens où elle peut affecter le nom de molécules, de principes actifs médicamenteux et « cacher » ainsi la demande de brevet aux yeux des concurrents. Il arrive également que la publication soit mauvaise parce que le corps du texte ne correspond pas au titre ou au résumé ou parce que le titre est vide, même si cela n'est pas explicitement interdit.

L'examen et le brevet délivré

Puis la demande de brevet est étudiée par un examinateur — qui y passe en moyenne 11,8 heures — et acceptée ou non après d'éventuels allers-retours avec le déposant. C'est le brevet publié immédiatement qui a valeur légale et fait foi en cas de litige devant les tribunaux. D'où son importance cruciale et le besoin d'une qualité quasi-irréprochable ! Pourtant, les erreurs mentionnées précédemment ne sont parfois pas corrigées. L'examinateur peut aussi obérer la qualité du brevet en rajoutant des erreurs. C'est par exemple le cas des codes de classification des brevets qu'il ajoute et sont parfois non pertinents. Plus grave, le filtre qu'est censé constituer l'examen laisse passer de nombreux brevets non conformes aux exigences des règlements des offices des brevets. Les membres du PDG estiment par exemple que dans les domaines technologiques arrivés à maturité, il est plus facile d'obtenir un brevet sur la foi d'une inventivité minime. L'équipe de J. Paradise a montré en 2005 sur un corpus de 74 brevets portant sur des séquences génétiques que 38 % des 1167 revendications examinées étaient problématiques, pour diverses raisons (revendications plus larges que la description, description incomplète ne permettant pas de reproduire l'invention, absence de caractère inventif, lien entre gène et maladie ou application clinique défini statistiquement donc pas forcément prouvé etc.). On n'est pas loin des « "brevets de papier" sans dispositif technique probant » annoncés par M. Cassier et J.-P. Gaudillière.

D'autre part, on ne peut que constater la tendance générale à la complexification croissante des demandes qui sont déposées et des brevets qui sont délivrés. En chimie, les structures de composés spécifiques (l'aspirine par exemple) ont été remplacés par des structures génériques dites « de Markush » à partir de 1923 (voir un exemple sur la figure ci-dessous). Celles-ci ont atteint leur paroxysme dans la revendication croissante de composés décrits comme A-B-C-D-E avec des définitions s'étalant sur des dizaines de pages pour les substituants A, B, C, D et E ! De ce fait, un nombre quasi-infini de composés peuvent être revendiqués et protégés. C'est aussi le cas avec la nouvelle habitude de décrire des entités par leurs propriétés physico-chimiques (viscosité, température de fusion, aromaticité etc.) plutôt que par leur nom ou leur structure… Plus récemment, c'est l'avènement de la chimie combinatoire et la revendication de bibliothèques de composés génériques qui a posé des problèmes à la profession ; en informatique, c'est l'extension (de fait) des brevets aux algorithmes et logiciels. Mentionnons aussi les méthodes d'affaires (business methods) qui ont intégré le giron des brevets à la fin des années 1990 et pour lesquelles les examinateurs étaient insuffisamment formés. Ce qui s'est produit à nouveau avec les brevets sur les gènes. Dans tous ces cas, la mauvaise qualité est en germe dans la perversion d'un système initialement destiné à protéger une invention technique unique et dans l'inadaptation des structures actuelles de contrôle et de régulation.

Enfin, nous devons souligner le cas des brevets « jumbo » en forte augmentation : ils représenteraient aujourd'hui 6 % des brevets totaux. Ces brevets XXL, qui peuvent atteindre plusieurs milliers de pages, plusieurs milliers de figures et compter jusqu'à 8900 revendications sont accusés de « noyer le poisson » et de délayer l'information en compilant des listes et des tableaux sans fin, bien éloignés de l'invention qui est censé être au cœur du brevet. Pourtant, la concision dans la description même est exigée par les règlements des offices des brevets — encore un abus et une manifestation des brevets de mauvaise qualité.

Conséquences pour le système des brevets

Cercle vicieux de la qualité

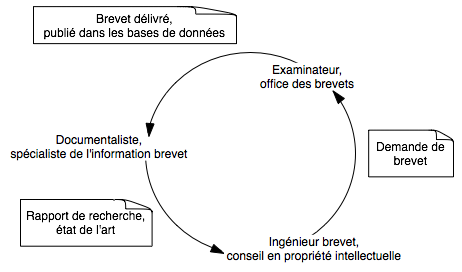

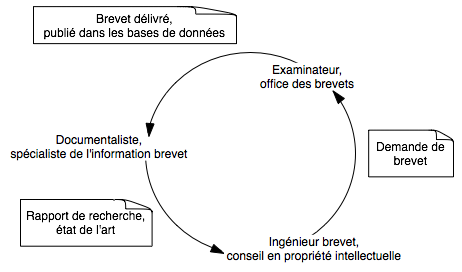

Le problème pourrait à la rigueur ne concerner que les « mauvais » déposants, dont la faible qualité des brevets ne pénaliserait qu'eux à travers le manque à gagner financier de droits de propriété intellectuelle bancals ou invalides. Mais le système fonctionne en vase clos et c'est la somme des efforts et qualités individuels qui participe à la robustesse totale. En oubliant à nouveau l'incidence sur l'image et l'efficacité extrinsèque, le simple cycle de vie des brevets permet d'expliciter ceci. Comme l'indique la figure ci-dessous, le documentaliste ou spécialiste de l'information brevet rédige un rapport de recherche avant rédaction de la demande de brevet ; celle-ci est transmise à l'examinateur qui l'examine par rapport à l'état de l'art mais aussi selon sa conformité aux exigences réglementaires (nouveau, inventivité, applicabilité industrielle, description complète et concise, unité d'invention etc.) ; le brevet (le cas échéant) et la demande de brevet sont publiés, s'ajoutant alors à l'état de l'art indexé et interrogeable dans les bases de données bibliographiques. Ainsi, les brevets de mauvaise qualité font les brevets de mauvaise qualité : si le brevet est mal renseigné, si l'information pertinente est noyée dans une masse de trivialités, si les revendications sont trop larges pour être trouvables lors d'une recherche dans les bases de données, il ne sera probablement jamais trouvé ni par le documentaliste ni par l'examinateur, d'où la délivrance de brevets douteux voire non valides. Ceux-ci ne seront d'aucune utilité pour l'entreprise et viendront alors « bruiter » un paysage technologique déjà bien encombré. Si un brevet extrêmement complexe est délivré, il va aussi compliquer le travail des conseils en propriété intellectuelle forcés à des circonvolutions et pourra dissuader un examinateur un peu pressé de délivrer un brevet sensiblement apparenté.

Ce cercle vicieux transparaît aussi quantitativement : la délivrance de brevets de mauvaise qualité signifie que la probabilité d'obtenir un brevet est forte, d'où une incitation au dépôt de brevets qui entraîne une augmentation du nombre de demandes de brevets, une surcharge de travail pour les examinateurs donc un examen plus superficiel et encore plus de brevets de mauvaise qualité délivrés.

Coût économique

Or qu'on ne s'y trompe pas : ces complications coûtent cher en temps, ressources et énergie. Les dépenses mondiales des entreprises de l'industrie pour leur information brevet (abonnements aux bases de données, outils et ressources nécessaires à la recherche, dissémination et veille de l'information etc.) s'élèvent déjà entre 2,5 et 3 milliards d'euros par an et l'on peut parier que cette somme devra croître dans l'avenir pour le même résultat. Si l'on jette juste un coup d'œil à l'extérieur du système, il apparaît immédiatement que ces coûts d'information accrus — et ceux des départements de propriété intellectuelle en général — ont un impact négatif sur les capacités d'innovation des entreprises. De plus, des brevets même de faible qualité suffisent à confisquer certaines recherches au secteur public, avec des répercussions à terme sur la société dans son ensemble.

Remèdes possibles

Pour les déposants

Comme le souligne M. Philipp, les solutions résident d'abord au niveau des déposants : « quality in, quality out ». Des ingénieurs brevets plus scrupuleux systématiquement associés à des spécialistes de l'information brevet efficaces devraient déjà réduire le nombre de demandes-poubelles. On pourrait aussi éduquer le public sur la nécessité de se renseigner sur l'état de l'art avant même d'entreprendre toute innovation.

Pour les offices des brevets

C'est probablement au niveau des offices des brevets — qui seraient aussi les premiers perdants d'un système auto-destructeur — que l'on peut agir le plus facilement. Les contraintes de temps — quand ce n'est pas de l'expertise — des examinateurs et l'absence de prise à bras le corps du problème sont majoritairement responsables de la situation actuelle. Ainsi, les offices des brevets pourraient encourager financièrement les déposants à rédiger des revendications concises et précises, faire respecter les exigences les plus élémentaires du droit des brevets, laisser plus de temps aux examinateurs par brevet examiné et multiplier leur nombre, procéder à un examen plus scrupuleux lorsque le coût social du brevet est plus élevé (cas des brevets sur les gènes humains) ou autre. Réformés plus profondément, ils pourraient remplacer le critère d'étape inventive (inventive step) par celui de degré d'inventivité suffisant (degree of inventiveness) déjà mis en œuvre par l'Office allemand des brevets ou conditionner l'actuelle indexation des primes des examinateurs sur le nombre de brevets délivrés à un critère de qualité.

Apport de modèles économétriques

Cependant, des modèles économétriques semblent indiquer qu'il serait moins coûteux et plus efficace de ne pas chercher à dissuader ex ante les déposants de demander des brevets ni d'améliorer l'étape d'examen des brevets et de laisser l'examinateur faire des erreurs, selon le principe de l'« ignorance rationnelle » de l'office des brevets. A la place, les déposants pourraient être pénalisés ex post si leur brevet est rejeté sur la foi de l'art antérieur et une procédure d'opposition calquée sur celle en vigueur à l'OEB viendrait remplacer l'inefficace ré-examen de l'Office américain des brevets (USPTO). On peut évidemment critiquer cette solution qui favorise les grandes firmes possédant les ressources nécessaires pour mener les recherches de brevetabilité et supporter le coût des opposition et litige, à l'inverse des petites et moyennes entreprises, et qui ne prend pas en compte le « bruitage » du paysage technologique que cela entraîne. Mais elle montre que si l'on cherche à intégrer tous les coûts, la réponse est peut-être moins évidente et intuitive qu'il n'y paraît.

Cas particulier des brevets logiciels et informatiques

Notons que pour l'informatique et les brevets logiciels, la mauvaise qualité est souvent due au fait qu'il est difficile de faire un examen exhaustif au vu de la masse et de la dispersion de l'état de l'art (contenu de fait dans les milliards de lignes de code passées et présentes). C'est pour cela qu'une solution intelligente résiderait dans la mise en commun des ressources et expertises pour l'examen ouvert des brevets logiciels et informatiques. C'est le but de l'expérience de Community Patent Review sur laquelle planchent depuis 2005 l'USPTO et IBM : elle propose depuis 2007 à tous les acteurs et experts volontaires d'être alertés en temps réel de la publication des demandes de brevets qui satisfont certains critères de leur choix (nom du déposant, mots clés, classification thématique etc.), de prendre part ensuite à des discussions permettant d'enrichir l'examen et d'apporter des informations sur l'état de l'art et enfin de profiter d'un retour sur la procédure et le devenir des informations échangées. En parallèle, dans une perspective claire d'amélioration de la qualité des brevets, l'USPTO en collaboration avec l'Université de Pennsylvanie devait lancer en 2007 un indicateur expérimental, le Patent Quality Index. Celui-ci est destiné à fournir une mesure quantitative de la conformité des brevets avec les exigences réglementaires et sera calculé à partir d'indices mesurables comme le nombre de citations d'autres publications, la taille et le nombre de revendications ou l'adéquation entre la description et les revendications. L'algorithme de calcul et l'indicateur lui-même seront rendus publics et pourront être améliorés, critiqués, discutés dans une démarche de construction par la communauté. La finalité de cet indicateur est de servir l'office des brevets autant que les acteurs publics et privés du secteur tout en sensibilisant à la question de la qualité des brevets.

Perspectives : la faillite d'un système ?

Est-ce que cette menace des brevets de mauvaise qualité suffit à mettre en cause un système qui en a vu d'autres ? Cela se pourrait bien, oui, à moyen ou long terme. Notamment en comparaison d'un système ouvert et décentralisé, alternatif au système des brevets. Par exemple, la licence BIOS promue par le Centre pour l'application de la biologie moléculaire à l'agriculture mondiale (CAMBIA) — même si elle est limitée aux biotechnologies — laisse aux inventeurs la propriété de leurs inventions et autorise toute utilisation et modification par quiconque à condition que les technologies modifiées soient aussi sous licence BIOS. De ce fait, les technologies s'enrichissent les unes les autres et tout les acteurs ont intérêt à la qualité, de la même façon que la qualité des publications scientifiques émerge naturellement de l'auto-organisation de la communauté scientifique. Seul l'avenir nous dira la viabilité comparée des deux système mais la question étant brûlante et d'importance, il est de toute façon essentiel qu'elle soit traitée avec la volonté nécessaire au plus haut niveau.

Derniers commentaires